CENTRE DE COMPETENCES

IA pour les systèmes critiques

Les récents progrès en Intelligence Artificielle, notamment en termes de Machine Learning, ont suscité un intérêt sans précédents, surtout de la part des industriels. Cependant, des obstacles scientifiques persistent encore.

Le Machine Learning et, plus particulièrement, les réseaux de neurones profonds, peuvent prétendre à des applications critiques telles que les véhicules autonomes ou le diagnostic médical, mais leurs propriétés théoriques ne sont pas encore bien connues.

Il est donc difficile de répondre aux contraintes industrielles requises pour une application critique, telles que la certification, la qualification, et l'explicabilité des algorithmes.

Notre objectif est de créer des connaissances autour de différents sujets :

- Les normes, les règlementations : comment déterminer de nouvelles directives de certification qui augmenteront la confiance dans les systèmes complexes et adaptatifs ;

- La définition des défis algorithmiques et mathématiques de l'intégration des algorithmes d'apprentissage automatique (y compris les réseaux neuronaux) dans les systèmes critiques.

- Le développement de nouveaux algorithmes et cadres mathématiques présentant des propriétés améliorées en matière de certification et de qualification.

- Les processus de développement (modèle de conception) et de maintenance/correction incrémentielle des systèmes basés sur l'IA ;

- L’intégration de l'IA : quantification/réduction de la mise en œuvre des réseaux neuronaux, évaluation des performances, concernant des infrastructures/matériaux spécifiques.

Domaines R&T

ELIMINATION DES BIAIS ET DES INFRMATIONS SENSIBLES DANS LES DONNEES D'APPRENTISSAGE

Proposer et démontrer des solutions où les décisions ne sont pas influencées par des biais (connus et inconnus), qui pourraient causer des systèmes d'apprentissage automatique biaisés et, donc, des décisions non fiables.

Nous définissons un cadre pour comprendre les effets de la distribution des échantillons dans le processus d'apprentissage automatique. L’impact de la maîtrise des biais est essentiel sur la détection d'anomalies, les questions de robustesseset d’explicabilité, ainsi que la résilience des algorithmes aux modifications de leur environnement.

GARANTIES THÉORIQUES POUR LA GÉNÉRALISATION

Les réseaux neuronaux ont démontré une impressionnante capacité de généralisation malgré un nombre élevé de paramètres. Cette capacité est encore mal comprise d'un point de vue théorique et il n'est donc pas possible de la garantir.

Nous définissons de nouvelles méthodes, conditions et outils pour avoir plus de garanties sur le comportement des réseaux de neurones. Ces nouvelles méthodes permettent, sous des hypothèses données, d'avoir une meilleure confiance dans la robustesse des algorithmes d'apprentissage profond, tout en proposant plusieurs indicateurs. Ceux-ci pourraient être utilisés pour convaincre les autorités compétentes lors du processus de certification.

ROBUSTESSE PAR LA DÉTECTION ET L'ADAPTATION AUX DONNÉES INCONNUES

Tout le mécanisme des techniques d'apprentissage automatique repose sur l'hypothèse que l'échantillon d'apprentissage transmette toutes les informations des données. L'algorithme n'est donc capable d'apprendre que ce qui est observé dans les données utilisées pour s'entraîner.

Ainsi, aucune nouveauté ne peut être prévue à l'aide des méthodes standard, alors qu'en pratique un nouveau comportement peut apparaître dans les données observées. Nous définissons et développons des outils pour détecter les observations inconnues et pour pouvoir les utiliser afin de mettre à jour et augmenter la capacité des algorithmes (y compris les réseaux neuronaux profonds).

EXPLICABILITE

Les algorithmes d'apprentissage automatique sont conçus pour assister les experts en leur proposant des prédictions construites à partir d’exemples. Ces algorithmes tendent même à remplacer les décisions humaines dans de nombreux domaines, en atteignant des performances extrêmement élevées. Au cours des dernières décennies, la complexité de ces algorithmes a augmenté, passant de modèles de prédiction simples et interprétables basés sur des règles de regression, à des modèles très complexes tels que le random forest, le gradient boosting et les réseaux neuronaux profonds.

Les modèles en question sont conçus pour maximiser la précision de leurs prédictions au détriment de l'interprétabilité de la règle de décision. On sait finalement peu de choses sur la manière dont l'information est traitée. Cela explique pourquoi ces modèles sont encore largement considérés comme des boîtes noires.

Nous définissons et développons des outils permettant aux spécialistes des données de prendre en compte les contraintes d'explicabilité. Nous définissons également des métriques qui permettent une évaluation objective des performances des algorithmes d'explicabilité.

Notre offre

- États de l'art, synthèses techniques

- Boîtes à outils spécifiques

- Démonstrateurs et prototypes

- Savoir-faire

- Bases de données et modèles

- Contributions au Technological Readiness Level (maturité technologique)

- Rapports de theses, publications scientifiques, conférences

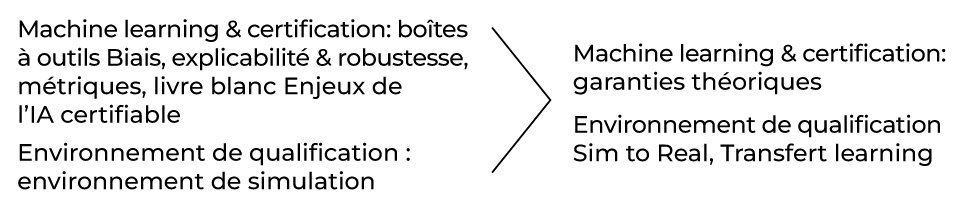

FEUILLE DE ROUTE

2019 > 2025

contactez-nous

Contactez notre équipe d'experts plateformes