L’été 2022 a été le théâtre d’une combinaison d’évènements climatiques inédite en Europe de l’ouest. En France en particulier, la plus grande partie du pays a étouffé durant trois vagues de chaleur successives qui ont battu tous les records, avec le thermomètre atteignant 39.3°C en Juillet à Brest.

Venant s’ajouter à un déficit de précipitations, la chaleur a favorisé la sècheresse et a rendu les végétaux particulièrement inflammables. Le pays a été victime de feux exceptionnels, comme ceux survenus à Landiras, dans le sud de la Gironde, qui ont brulés en deux fois plus de 20.000 hectares.

Dans une tentative de réponse au dérèglement climatique et ses conséquences, l’Institut de Recherche Technologique IRT Saint Exupéry étudie des solutions technologiques basées sur l’IA et les réseaux de neurones artificiels pour détecter les feux de forêt au plus tôt depuis des satellites en orbite.

Au vu de l’importance du sujet, nous avons décidé de communiquer publiquement nos résultats qui ont été présentés dans un article à CNIA 2022 (Conférence Nationale sur l’Intelligence Artificielle). Exceptionnellement, nous avons également décidé de publier l’ensemble de nos jeux de données, que nous sommes ravis de rendre disponibles à la communauté scientifique ci-dessous. Ces travaux ont été réalisés dans le cadre du projet CIAR (Chaîne Image Autonome et Réactive) mené à l’IRT Saint Exupéry. Nous aimerions remercier nos partenaires académiques et industriels pour leurs contributions : Thales Alenia Space, Activeeon, Avisto, ELSYS Design, MyDataModels, Geo4i, INRIA et le LEAT/CNRS.

A PROPOS DE L’ARTICLE CNIA 2022

« Modèle et jeu de données pour la détection multi-spectrale de feux de forêt à bord de satellites »

Abstract

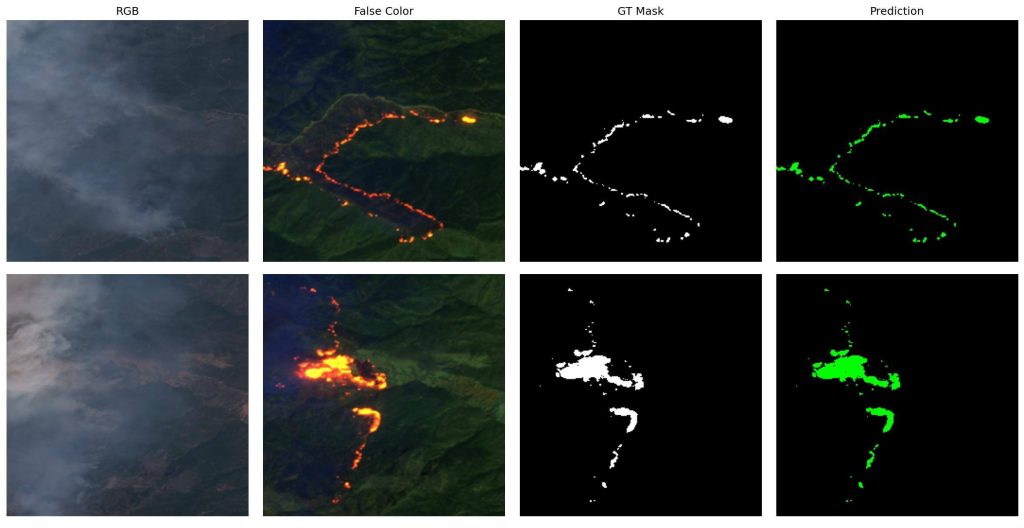

Le nombre de feux de forêts risque d’augmenter de 50% d’ici à 2100. Dans cet article, nous nous intéressons à la télédétection de ces feux à bord d’un satellite afin de lever des alertes précoces directement depuis l’espace. Dans ce cadre, nous avons entraîné un réseau de neurones UNetMobileNetV3 à segmenter des images multispectrales de Sentinel-2. Nous avons ensuite déployé ce réseau sur un GPU embarquable dans un satellite en orbite basse.

Auteurs : Houssem Farhat, Lionel Daniel, Michael Benguigui et Adrien Girard.

Plus d’informations sur la conférence CNIA 2022 et l’accès aux actes : ici

A PROPOS DU DATASET S2WDS (SENTINEL-2 WILDFIRE DATASET)

« Dans le cadre de ces recherches, nous avons exploité un jeu de 90 scènes satellites Sentinel-2, où les fronts d’incendies ont été pré-annotés automatiquement, puis corrigés manuellement. »

Nos jeux de données sont disponibles en deux versions :

Version 1 (GSD variable entre 40m et 80m) :

Cette version est celle décrite dans notre papier CNIA 2022 et qui doit être utilisée pour reproduire nos résultats. Dans cette première version, les images Sentinel-2 ont été téléchargées depuis l’API OGC WCS de Sentinel-Hub, et leur GSD varie de 40 à 80m. Les images ont ensuite été découpées en patchs de 256x256px et distribuées au sein de trois datasets différents afin d’entraîner, valider et tester une Intelligence Artificielle atteignant une performance d’IoU de 94%.

Version 2 (GSD constant égal à 20m) :

Cette seconde version de notre jeu de données a été produit peu de temps après la publication de notre article CNIA 2022. Cette fois, les images Sentinel-2 sont directement téléchargées depuis le service Copernicus, à la résolution maximale, et au niveau de traitement L1C. En dehors d’une stricte reproduction ou comparaison avec nos résultats publiés à CNIA 2022, nous recommandons l’usage de cette deuxième version pour toute future recherche, étant donné que tous les patchs du dataset ont ici un GSD constant égal à 20m.

Vous pouvez télécharger les deux version du jeu de données : ici

Nos résultats CNIA 2022 (basés sur S2WDS Version 1) sont reproductible via le code disponible : ici

Un code similiaire pour S2WSD Version 2 (postérieur à notre papier CNIA 2022) est disponible : ici

A PROPOS DU PROJET CIAR

« Le projet CIAR (Chaîne Image Autonome et Réactive) étudie les technologies permettant de déployer de l’Intelligence Artificielle pour le traitement de l’image dans des systèmes embarqués (satellites, drones de livraison, etc.). »

Pour cela, trois défis techniques sont relevés :

- Identifier les cas d’usage, et constituer des bases de données annotées pertinentes.

- Concevoir des Intelligences Artificielles performantes et adaptées aux contraintes des systèmes embarqués.

- Optimiser, implémenter sur cible matérielle, et évaluer les algorithmes sélectionnés.

Depuis plusieurs années, l’équipe CIAR collabore avec l’ESA (l’Agence Spatiale Européenne) sur la mission OPS-SAT. Le 22 Mars 2021, l’équipe a réalisé deux premières spatiales :

- La mise à jour à distance, depuis une station sol, d’un réseau de neurones artificiel embarqué sur un satellite.

- L’utilisation d’un FPGA (« Field-Programmable Gate Array ») pour déployer et utiliser ce réseau de neurones en orbite.

Plus d’informations sur ces premières spatiales : ici

INFORMATIONS CLES

Chiffres clés

Durée du projet : 5 ans (Juin 2018 – Juin 2023)

Budget: 6.5M € (financés en partie par le PIA)

Membres: 8

Membres industriels

Thales Alenia Space, Activeeon, Avisto, ELSYS Design, MyDataModels, Geo4i

Membres académiques

Tutelles étatiques

A PROPOS DE L’IMPACT ENVIRONNEMENTAL DE CETTE ETUDE

L’impact environnemental de cette étude est difficilement mesurable, mais il est important d’en connaître l’ordre de grandeur. En évaluant uniquement l’impact carbone de la consommation électrique induite par l’entrainement de notre Intelligence Artificielle, les auteurs estiment avoir émis environ 2kgCO2, soit environ 3000 fois moins que leur empreinte carbone personnelle qu’ils devront réduire par 5 en 2050 pour espérer respecter les +2°C des accords de Paris à la COP21.

Même si toute l’équipe est consciente de la situation environnementale actuelle, il est important de savoir que ce projet a pour but de contribuer à l’équilibre environnemental de notre planète. En effet, en détectant rapidement les feux de forêts depuis l’espace, un satellite pourrait directement alerter les humains à proximité et ainsi sauver des vies, la faune et la flore.